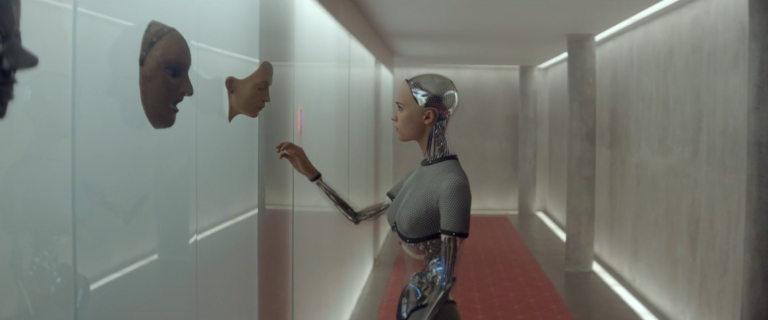

Open AI (l’entreprise qui a mis au point notamment ChatGPT et DALL-E) a annoncé en février 2024 la sortie de “Sora“. Sora est une intelligence artificielle permettant la génération de vidéos à partir de prompts. Pour l’instant, elle n’est pas disponible au public mais elle pose à nouveau la question des deepfakes.

Dans une vidéo récente (avril 2024), Defakator propose un panorama de l’état actuel des deepfakes:

– techniques actuelles: de la synchronisation des lèvres avec clonage de la voix, aux vidéos générées en passant par le “face swapping”,

– état de la réglementation : l’Union Européenne a produit un Artificial Intellience Act qui exige par exemple des IAs qu’elles soient sûres, transparentes, non discriminantes,

– quelques propositions pour nous aider à y voir plus clair: remonter à la source (la réclamer!), repérer des aberrations sur les vidéos générées.

La vidéo comprend de nombreux exemples et des exercices pratiques où serez mis à l’épreuve face à des vidéos fake.

Elle est longue (50 minutes) mais ça vaut la peine de suivre l’état de l’art sur les deep fakes car, comme le dit Defakator: “nos outils évoluent plus vite que nos humanités”.